說到語言模型的本地部署,大家的第一反應應該都是燒錢、燒顯卡,像世超的陳年老電腦,打個LOL都嗡嗡響,可以說就是那臺老古董毀了我的AI夢。

誒,那有沒有不吃配置,不吃鈔能力,普通人也能感受到本地部署AI的快感的方法呢?

有的兄弟,有的。

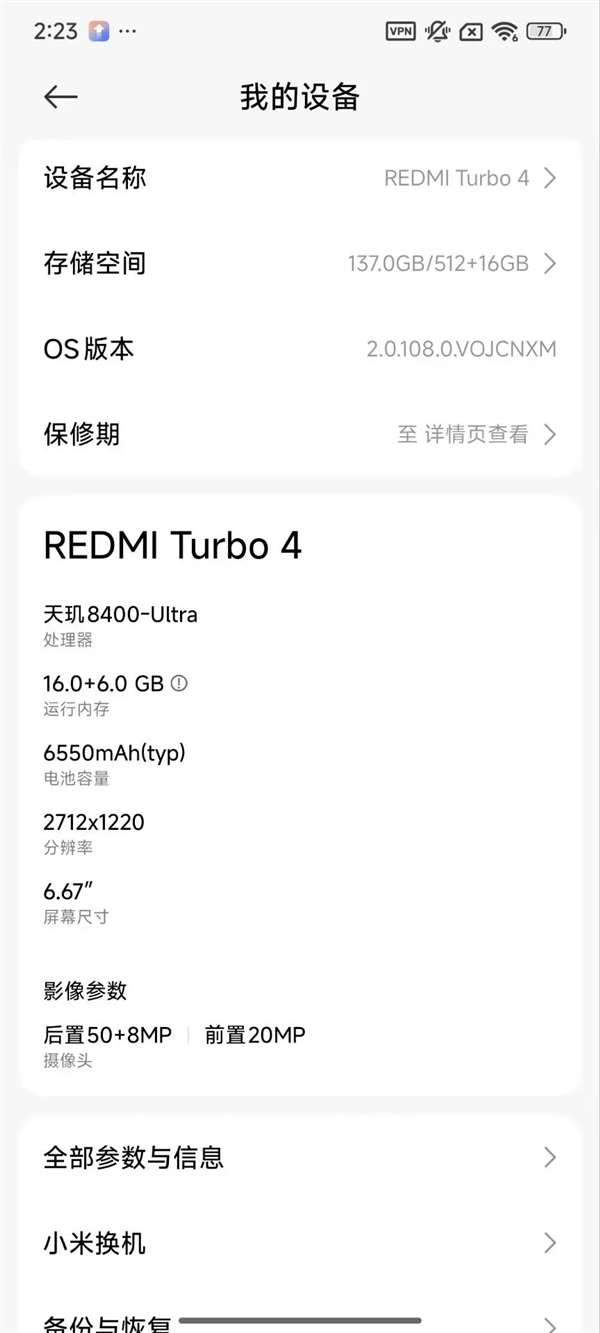

世超這臺2000元不到的紅米Turbo4,居然就能成功部署小米最新的語言模型Mimo-7B量化版。

在完全斷網的情況下,它也能一字一句地輸出正確的結果。

眾所周知,世超心里一直想著差友,所以第一時間趕來給大家出個保姆級教程,包含兩種方法。話不多說,準備凍手!

第一種方法,下載Pocketpal AI,這是一款專用于手機跑AI模型的應用程序。

然后打開它,點擊Download Model,再點右下角的 號,選擇Add From Hugging Face,然后搜索Mimo,選第一個版本下載就好。

不選后面的,是因為后面的數字越大,模型精度越高,咱這手機其實夠嗆。

最后回到主頁,點擊Select Model,就能選擇模型開始聊天了。

如果嫌麻煩,世超還準備了更簡單的方法,直接在瀏覽器輸入這個網址:

https://github.com/alibaba/MNN/tree/master/project/android/apps/MnnLlmApp,這是一款由阿里開發的端側多模態模型部署平臺。

往下滑到Release,點擊Download,下載這個APP,就可以隨意挑選下載你想體驗的本地模型了,甚至還能跑Stable Diffusion。。

OK,部署完成了,來給大伙看看效果吧。世超那天下班時候迷路了,不小心走到了亞馬遜的熱帶雨林,一格信號都沒有,我看是活不下去了。。于是我立馬掏出了我的Mimo,問他怎么鉆木取火。

不到三分鐘,他咣咣咣全給我寫出來了。

在這,咱小型模型的獨特優勢已經盡數體現了——無視環境,隨時隨地本地運行。

直接在手機上本地運行,就意味著不管在雪山、沙漠、海洋、甚至外太空,咱都能隨時隨地掏出這個私人助理。

那,要是再小一點呢?阿里之前剛發布的Qwen3,有個參數只有0.6B的模型,咱也在他們自家的MNN上試了一下。

嗯。。確實能說話,不過這說出來的話,好像有點深奧了。。

不過,這應該是和手機部署有關,MNN上的模型基本都是對移動端部署進行特殊優化過,防止手機跑崩,模型有些精度丟失也很正常,出現這種情況也只是概率事件。

總之,有了這些小型模型,咱以后去哪都能跟AI聊天了,坐飛船上趟火星也肯定不會無聊了。

有人說,你這是癔癥犯了,這輩子能上太空嗎?現在哪兒沒網啊,那么多大模型APP它哪個不香?

但小型模型的用處,還真不止這點。如果說,AI要想更貼近咱的生活,還真得是更小的模型。

要是AI發展到進家門了,你躺沙發上突然想看電視,喊AI幫你開個電視,這其實也就是個跑腿的活。但如果把指揮家具的都換成大模型,那得等它們上傳數據,深度思考,再把數據傳回來,估計還沒等電視打開,你就刷上短視頻了。

這就是參數少的另一個優點——低延遲。沒有那么多參數,它就不用考慮那么多東西,完全遵照主人的命令。

而且,參數量越小,訓練和部署的成本也就越低。據說,訓練一次 GPT-4o 這種級別的模型,就要燒掉 1 億美元,平民根本燒不起這么大的模型。所以AI公司每次開源新模型,都會放出各種尺寸,就是讓大家自由挑選適合自己的模型。

而很多小公司,都是垂直領域的專家,不需要大模型那樣的百科全書。

參數少的模型,可以用來被各行各業的公司自己訓練,不僅燒錢少,還能煉出一個該領域的專家。現在,有很多專業型模型已經在各自領域發光發熱。

像度小滿的金融模型的XuanYuan-6B,雖然只有6B,效果就非常好。在注冊會計師(CPA)、銀行從業資格、基金從業資格、證券從業資格等多項金融領域考試中,這玩意都能展示出金融領域專家的水平。

而現在,很多公司也在開始小型模型上全面發力,很多參數少的模型甚至能媲美大模型。

像咱的DeepSeek,愣是用一些新奇的算法,把參數少的模型性能懟了上去。DeepSeek-R1-Distill的7B和14B版本,在數學推理任務上能超越很多閉源大模型。

還有家叫面壁智能的公司,他們是專門搞端側模型的,目標就是手機、車機等移動設備,他們搞出的“小鋼炮”MiniCPM只有8B,測試表現居然能媲美GPT-4o。

而且,他們很早就把多模態能力塞進了小型模型里,實現了全模態、端到端。

就連蘋果都開始自研 3B 參數的模型了,他們的AFM-on-device,在文本總結任務中,其效果能優于Gemma、Phi-3 mini等更大參數的模型。

那問題又來了,這些模型參數這么少,又能趕上大模型,這又憑什么呢?

這些小東西還真有獨門秘籍。比如知識蒸餾這方法,就像讓老師給學生開小灶,讓大模型把學到的知識和經驗傳授給更小的模型。

以及剪枝、量化等方法,簡單說就是在不需要很高精度的情況下,把模型里的高精度計算變成低精度計算,這樣模型就能跑得更快。去年英偉達聯合Meta發布的 Llama-3.1-Minitron 4B AI 模型,就是從原本的8B模型剪枝而來,讓模型速度更快,資源更省。

最后還有一招,叫混合專家模型(MoE)。傳統大模型就像個齊心協力的專家組,不管什么問題,都得全組抄家伙上陣。而 MoE 架構的作用,就是把這群專家拆分成 n 個專業小組:有的專門搞數學推導,有的專精語義分析,還有的負責圖像識別。。這樣,遇到小問題就不需要“全員加班”了。

所以,別看這些模型個頭小,說不定就是邁向AI世界的又一大步。就像科技進步從不是一蹴而就的,咱普通人,就靜待開花結果就好。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播更多信息之目的,如作者信息標記有誤,請第一時間聯系我們修改或刪除,多謝。